信息信息是用来消除随机不确定性的东西。也就是说,衡量信息量的大小就看这个信息消除不确定性的程度。克劳德.香农(ClaudeShannon)被称为“信息论之父”。他一生中也许是最有名的一篇论文:《通讯的数学理论》(Amathematicaltheoryofcommunications,1948),引入

信息是用来消除随机不确定性的东西。也就是说,衡量信息量的大小就看这个信息消除不确定性的程度。

克劳德.香农(Claude Shannon)被称为“信息论之父”。他一生中也许是最有名的一篇论文:《通讯的数学理论》(A mathematical theory of communications,1948),引入了一条全新的思路,震撼了整个科学技术界,开启了现代信息论研究的先河。在这一伟大的贡献中,他引进的“信息熵”之一般概念举足轻重:它在数学上量化了通讯过程中“信息漏失”的统计本质,具有划时代的意义。

信息量的大小和事件发生的概率成反比。

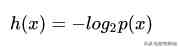

信息量的表示:

x 表示一个发生的事件;

p 表示这个事件发生的先验概率;先验概率指这个事件按照常理,按照一般性规律发生百思特网的概率。

可以认为是信息的杂乱程度的量化描述。

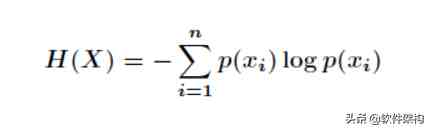

信息熵公式如下:

其中,x 可以当成一个向量,就是若干个 x 百思特网产生的概率p(x)乘以该可能性的信息量-logp(x),然后各项做加和。

信息量度量的是一个具体事件发生所带来的信息,而熵则是在结果出来之前对可能产生的信息量的期望—考虑该随机变量的所有可能取值,即所有可能发生事件所带来的信息量的期望。

信息熵还可以作为一个系统复杂程度的度量,如果系统越复杂,出现不同情况的种类越多,那么他的信息熵是比较大的。

如果一个系统越简单,出现情况种类很少(极端情况为1种情况,那么对应概率为1,那么对应的信息熵为0),此时的信息熵较小。

小结

在信息可能有N种情况时,如果每种情况出现的概率相等,那么N越大,信息熵越大。

在信百思特网息可能有N种情况时,当N一定,那么其中所有概率相等时,信息熵是最大的。

简而言之,

信息越确定,越单一,信息熵越小;

信息越不确定,越混乱,信息熵越大。