原标题:《AI正在疯狂污染中国互联网》

污染中国互联网,AI成为“罪魁祸首”之一。

事情是这样的。

最近大家都热衷于咨询AI。 有网友向Bing提出了这样一个问题:

象鼻山有缆车吗?

Bing也在答题,给出了一个看似靠谱的答案:

在给出肯定答复后,必应还贴心附上了票价、营业时间等细节。

不过这位网友并没有直接采纳这个答案,而是顺着线索点击了下方的“参考链接”。

就在这时,网友发现了不对劲——这个人的回答怎么这么“聪明”。

于是他点开了这个名为“百变人生”的用户主页,恍然大悟,原来杰是个AI!

因为这个用户回答问题的速度非常快,几乎每1、2分钟就能解决一个问题。

甚至可以在 1 分钟内回答 2 个问题。

在这位网友更仔细的观察下,他发现这些回答的内容都是未经验证的……

而且,他认为,这就是导致 Bing 输出错误答案的原因:

这个AI正在疯狂污染中国互联网。

“AI污染源”,不止这个

那么现在的AI用户是如何被网友发现的呢?

从目前的结果来看,他已经被知乎“判”为沉百思特网默状态。

不过尽管如此,也有网友直言:

超过一个。

如果你点开知乎的“等待你的回答”栏目,随便找一个问题,向下滚动,你确实会遇到很多“机智”的答案。

比如我们在“AI在生活中有哪些应用场景?”的回答中找到了一个:

不仅答案的语言是“极言极语”,甚至连答案都直接贴上了“包括AI辅助创作”的标签。

然后如果我们抛出这个问题,答案是……好吧,这几乎是一回事。

事实上,这样的“AI污染源”并不仅限于这个平台。

即便是简单的科普图片这件事,AI也屡屡失误。

网友们也纷纷驻足蚌埠:“好家伙,一张图都不是贻贝。”

甚至各种人工智能生成的假新闻也并不少见。

比如前段时间,有一则轰动一时的新闻在网络上疯传。 标题是“郑州鸡扒店杀人案,男子用砖头将女子打死!” ”。

但实际上,这条新闻是江西人陈某为了吸粉而制造的。

无独有偶,广东深圳的洪师兄也利用AI技术发布了“今天早上,甘肃一列火车撞毁修路工人,9人死亡”的假新闻。

具体来说,他通过全网搜索近年社会热点新闻,并利用人工智能软件对新闻时间、地点等进行修改编辑,进而在某些平台上博取关注和流量,谋取不法利益。

警方已对其采取刑事强制措施。

但实际上,这种“AI污染源”现象不仅存在于中国,在国外也同样存在。

程序员问答社区 Stack 就是一个例子。

早在去年年底刚火起来的时候,Stack 就突然宣布“暂时停用”。

当时官方给出的理由是这样的:

(这样做的)目的是减缓使用 USE 创建的大量答案流入社区的速度。

因为答错的概率太高了!

Stack 进一步阐述了这种现象。

他们认为,之前用户回答的问题被其他具有专业知识背景的用户浏览过,正确与否等同于验证。

但自从它出现以来,大量人们认为“正确”的答案出现了; 并且具有专业知识背景的用户数量有限,不可能阅读所有这些生成的答案。

除了回答这些专业问题,它的错误率也是真的存在; 因此 Stack 选择禁用它。

简而言之,人工智能污染了社区环境。

和美版贴吧一样,有更多的版块和话题:

很多用户会在这个栏目下提出各种问题,bot也会一一解答。

不过还是个老问题,答案的准确性不得而知。

但这种现象的背后,其实隐藏着更大的隐患。

滥用人工智能,也毁了人工智能

人工智能模型获取了大量的互联网数据,但无法很好地区分信息的真实性和可信度。

结果是我们不得不应对大量快速生成的低质量内容,让人头晕目眩。

很难想象如果用这种数据训练这些大型模型会是什么结果……

而这样滥用AI,反过来也是一种自噬。

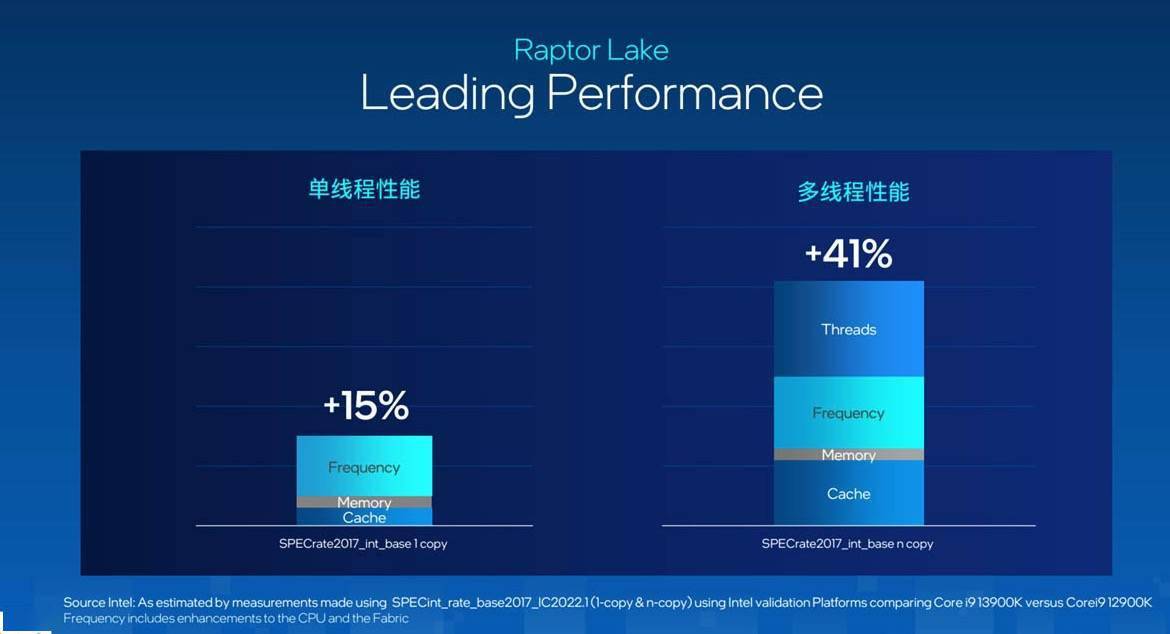

最近,英国和加拿大的研究人员在 arXiv 上发表了一篇题为“The Curse of : on Data Makes”的论文。

探索人工智能生成的内容污染互联网的现状,然后发布一个令人担忧的发现,即使用模型生成的内容来训练其他模型可能会导致生成的模型出现不可逆转的缺陷。

人工智能生成数据的这种“污染”会扭曲模型对现实的感知,未来通过抓取互联网数据来训练模型会变得更加困难。

论文作者、剑桥大学和爱丁堡大学安全工程教授罗斯直言:

就像我们用塑料垃圾填满海洋,用二氧化碳填满大气一样,我们即将用废话填满互联网。

对于虚假信息满天飞的情况,Brain 高级研究科学家达芙妮伊波利托 ( ) 表示:未来要找到未经 AI 训练的高质量数据会更加困难。

如果满屏都是这种没有营养的劣质信息,如此循环往复,那AI以后就没有数据训练了,输出的结果也就没有意义了。

基于这种情况,大胆想象一下。 一个在垃圾和虚假数据环境中成长起来的AI,在进化成人类之前,可能会被装进一个“弱智机器人”,一个智力低下的智障机器人。

正如1996年百思特网的科幻喜剧电影《丈百思特网夫与篮子》一样,该片讲述了一个普通人克隆自己,再克隆一个人,每一次克隆都导致克隆人的智力水平呈指数级下降,而其智力水平却不断提高的故事。愚蠢。

到那时,我们可能不得不面对一个荒谬的困境:人类创造了一个能力惊人的人工智能,但它却充满了无聊和愚蠢的信息。

如果人工智能只输入虚假的垃圾数据,我们可以期望它们创建什么样的内容?

如果时间到了那个时候,我们很可能会怀念过去,向那些真正的人类智慧致敬。

话虽如此,这也不全是坏消息。 比如一些内容平台已经开始关注AI产生的劣质内容问题,出台相关规定进行限制。

一些人工智能公司也开始开发能够识别人工智能生成内容的技术,以减少人工智能虚假信息和垃圾信息的爆发。

参考链接: